Didattica → Informatica → Hardware e Software

Prima di addentrarci nel mondo dell’informatica, dovremmo sapere cos’è l’informatica.

La parola informatica fu coniata per la prima volta da uno scienziato francese (un informatico) Philippe Dreyfus nel 1962 (informatique). Essa è composta da due parole:

Queste due parole sintetizzano la seguente definizione di informatica:

Scienza/disciplina che tratta l’elaborazione delle informazioni (intesa come creazione, memorizzazione e scambio di dati) in maniera automatizzata attraverso dispositivi tecnologici informatici (oggi elettronici) appartenenti ad una specifica categoria che prende il nome di Computer

La citazione nella definizione delle due parole scienza e disciplina è d’obbligo in quanto possiamo vedere l’informatica come una disciplina da un punto di vista didattico in quanto materia di insegnamento a scuola e università ma anche come scienza in quanto espressione di conoscenza in continua evoluzione attorno ad essa.

Dalla definizione fornita precedentemente è evidente che al centro dell’informatica vi è l’Informazione e lo strumento che ci permette di manipolarla cioè il Computer.

Fig. 1 - Schema di funzionamento di un Computer

Si distinguono le seguenti fasi:

A questo punto sorge spontanea la domanda: come devono essere i dati che immettiamo e di che natura saranno quelli che riceviamo? In altre parole, qual è il linguaggio utilizzato dal Computer? Certamente non quello umano!

La risposta alla domanda risiede nella natura fisica del Computer che è basata come detto su circuiti elettronici.

Per questo motivo il computer sa riconoscere solo due stati diversi:

Il Computer, durante il suo funzionamento, è sempre accesso ed alimentato dalla corrente. Il termine spento e acceso, si riferisce alla capacità del computer, attravero un interruttore, di far passare o meno la corrente che riceve dalla presa, all’interno dei suoi circuiti.

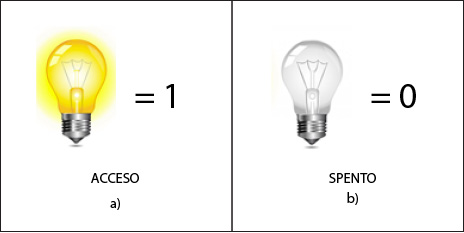

Possiamo immaginare, come esempio, di avere nel computer una “lampadina” che può essere accesa o spenta. Potremmo dunque associare a questi due stati due informazioni, il valore 1 (vero) al passaggio di corrente e il valore 0 (falso) al “non” passaggio di corrente (Fig. 2). Se possiamo dunque in qualche modo rappresentare con un computer i numeri 1 e 0 appartenenti al sistema binario, possiamo anche sfruttare quella branca della matematica e della logica conosciuta come Algebra di Boole.

Fig. 2 - I due stati che un Computer può rappresentare a) acceso (1) e b) spento (0)

Quindi con una sola “lampadina” possiamo rappresentare solo due informazioni.

Immaginiamo, però, che nel nostro Computer esistano più “lampadine”, ad esempio due.

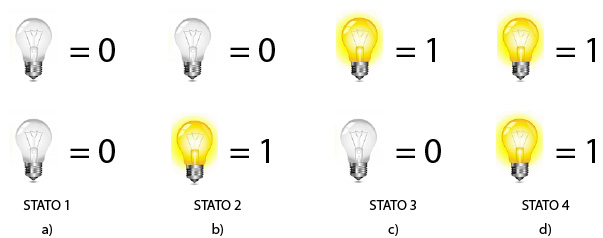

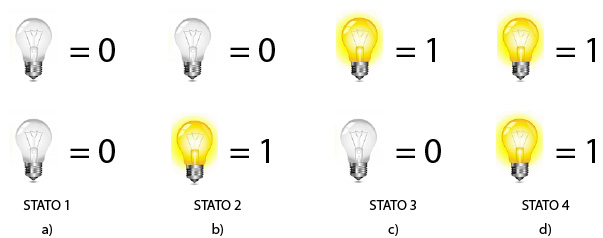

Possiamo avere le seguenti combinazioni.

Fig. 3 - I quattro stati rappresentabili con due lampadine a) spento-spento (00), b) spento-acceso (01), c) acceso-spento (10) e acceso-acceso(11)

Con due “lampadine” abbiamo la possibilità di rappresentare 4 stati diversi (4 informazioni).

Se volessimo dunque rappresentare i primi quattro numeri interi, potremmo associare ognuno di essi ad ogni singolo stato:

Si può dunque dire, più in generale, che con n “lampadine” avremo:

2n possibili informazioni rappresentabili

Chiameremo d’ora in poi ogni "lampadina" un bit. Questa parola in inglese significa “un pò” come a dire quindi un “pezzetto” di informazione. Per convenzione si è scelto di rappresentare l’informazione generata ed interpretata dal computer a gruppetti di 8 bit che costituiscono 1 byte.

L’insieme di questi gruppetti di byte, vanno a costituire la memoria digitale che può essere di diverse misure (multipli di byte).

Sembra abbiamo trovato un modo, quindi, per rappresentare l'insieme dei numeri interi (ovviamente fino ad un certo limite stabilito dal numero totale di “lampadine”) usando un linguaggio interpretabile dal computer cioè il linguaggio binario detto anche liguaggio macchina basato sui due simboli del sistema binario (1 e 0).

Però sappiamo benissimo che un Computer non rappresenta solo numeri ma anche caratteri alfanumerici (le lettere), immagini e suoni.

Nulla ci vieta di utilizzare una serie di combinazioni “spento-acceso” di una serie di “lampadine” per rappresentare anche lettere, immagini e suoni.

Fig. 1 - Tabella ASCII

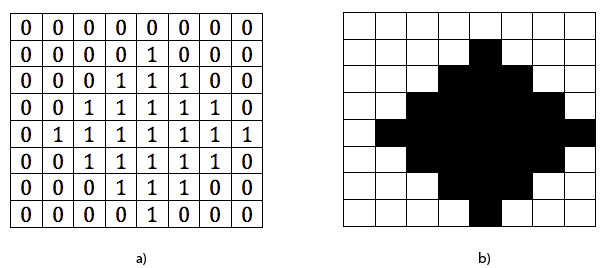

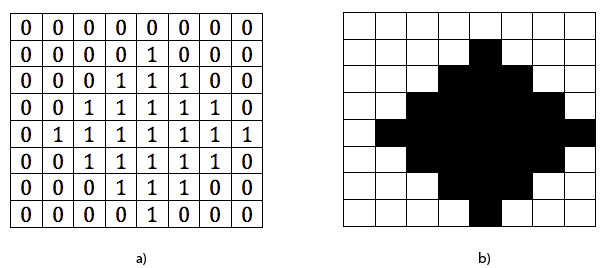

Immaginiamo una griglia di un certo numero di celle e immaginiamo di riempirla di 0 e 1 con il sitema binario di cui abbiamo parlato. Con il valore 1 rappresenteremo il colore nero mentre con il valore 0 il valore bianco (Fig. 2).

Fig. 2 - Codifica bitmap

Abbiamo rappresentato, con una qualità approssimativa, un rombo. La disposizione delle celle a forma di griglia è una operazione che compirà il monitor che alla ricezione delle informazioni dal nostro Computer come sequenza di 1 e 0. Queste celle sono dette Pixel e la loro codifica è detta codifica bitmap.

Ovviamente possiamo aumentare il numero di bit per celle e rappresentare anche altri colori, oppure aumentare il numero di celle della griglia per ottenere una “qualità” dell’immagine (in termini di dettagli) maggiore che chiameremo risoluzione (densità di pixel in un determinate spazio lineare).

Dietro lo stesso concetto, c’è la rappresentazione dei video. Un video altro non è che una sequenza di immagini che vengono mostrate una dopo l'altra ad una certa velocità. Maggiore è il numero di immagini mostrate al secondo, maggiore è la fluidità del video.

Un suono corrisponde fisicamente ad un’onda sonora (pressione dell’aria in un intervallo di tempo), in base all’ampiezza e alla frequenza di tale onda sonora, percepiamo un suono piuttosto che un altro.

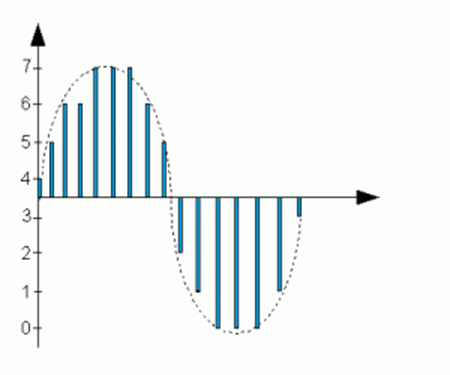

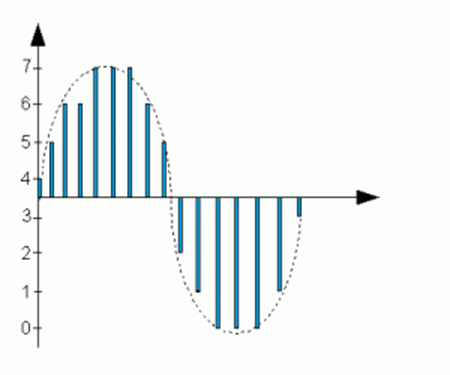

A partire da una onda sonora è possibile, attraverso una procedura detta campionamento codificare l’onda stessa in sequenza di valori binari 1 e 0. Il campionamento (Fig. 3) avviene ad ogni intervallo scelto di tempo. Più gli intervalli sono stretti e maggiore è l’accuratezza del campionamento. Questo livello di accuratezza è detto scala e può variare da 8 a 32 bit nell’unità di tempo.

Fig. 3 - Campionamento

Ora che sappiamo come “comunicare” con il Computer e quale linguaggio utilizzare, dobbiamo trovare un modo per “istruirlo” sul tipo di elaborazione che deve effettuare. Ad esempio potremmo volere che il nostro computer effettuasse un calcolo matematico come una somma, una differenza oppure un calcolo logico come un confronto tra numeri per sapere se sono uguali, o uno è maggiore dell’altro e viceversa.

La caratteristica in base alla quale un computer esegue un tipo di operazione piuttosto che un altro è detta programmabilità.

Dobbiamo quindi fornire un programma al computer cioè un insieme di istruzioni in modo tale da poterlo istruire sulle operazioni che vogliamo esegua.

Hardware e Software

Prima di addentrarci nel mondo dell’informatica, dovremmo sapere cos’è l’informatica.

La parola informatica fu coniata per la prima volta da uno scienziato francese (un informatico) Philippe Dreyfus nel 1962 (informatique). Essa è composta da due parole:

- Informazione

- Automatizzata

Queste due parole sintetizzano la seguente definizione di informatica:

La citazione nella definizione delle due parole scienza e disciplina è d’obbligo in quanto possiamo vedere l’informatica come una disciplina da un punto di vista didattico in quanto materia di insegnamento a scuola e università ma anche come scienza in quanto espressione di conoscenza in continua evoluzione attorno ad essa.

Dalla definizione fornita precedentemente è evidente che al centro dell’informatica vi è l’Informazione e lo strumento che ci permette di manipolarla cioè il Computer.

Cos’è dunque un Computer?

Un computer è una macchina composta da un insieme complesso di circuiti elettronici che consente di eseguire, automaticamente e in maniera ripetitiva, operazioni logico-aritmetiche in base a dei dati di ingresso (input) restituendo dei dati in uscita (output). Dunque, in maniera semplicistica, potremmo rappresentare il funzionamento di un computer con il seguente schema (Fig. 1).

Fig. 1 - Schema di funzionamento di un Computer

Si distinguono le seguenti fasi:

- Fase di input: l’utente immette dei dati all’interno del Computer;

- Fase di elaborazione: il computer elabora i dati inseriti nella fase precedente;

- Fase di output: il computer restituisce all’utente nuovi dati risultato dell’elaborazione della fase precedente;

A questo punto sorge spontanea la domanda: come devono essere i dati che immettiamo e di che natura saranno quelli che riceviamo? In altre parole, qual è il linguaggio utilizzato dal Computer? Certamente non quello umano!

La risposta alla domanda risiede nella natura fisica del Computer che è basata come detto su circuiti elettronici.

Per questo motivo il computer sa riconoscere solo due stati diversi:

- Spento (nessun passaggio di corrente)

- Acceso (passaggio di corrente)

Il Computer, durante il suo funzionamento, è sempre accesso ed alimentato dalla corrente. Il termine spento e acceso, si riferisce alla capacità del computer, attravero un interruttore, di far passare o meno la corrente che riceve dalla presa, all’interno dei suoi circuiti.

Possiamo immaginare, come esempio, di avere nel computer una “lampadina” che può essere accesa o spenta. Potremmo dunque associare a questi due stati due informazioni, il valore 1 (vero) al passaggio di corrente e il valore 0 (falso) al “non” passaggio di corrente (Fig. 2). Se possiamo dunque in qualche modo rappresentare con un computer i numeri 1 e 0 appartenenti al sistema binario, possiamo anche sfruttare quella branca della matematica e della logica conosciuta come Algebra di Boole.

Fig. 2 - I due stati che un Computer può rappresentare a) acceso (1) e b) spento (0)

Quindi con una sola “lampadina” possiamo rappresentare solo due informazioni.

Immaginiamo, però, che nel nostro Computer esistano più “lampadine”, ad esempio due.

Possiamo avere le seguenti combinazioni.

Fig. 3 - I quattro stati rappresentabili con due lampadine a) spento-spento (00), b) spento-acceso (01), c) acceso-spento (10) e acceso-acceso(11)

Con due “lampadine” abbiamo la possibilità di rappresentare 4 stati diversi (4 informazioni).

Se volessimo dunque rappresentare i primi quattro numeri interi, potremmo associare ognuno di essi ad ogni singolo stato:

- spento-spento = 00 → 0

- spento-acceso = 01 → 1

- acceso-spento = 10 → 2

- acceso-acceso = 11 → 3

Si può dunque dire, più in generale, che con n “lampadine” avremo:

Chiameremo d’ora in poi ogni "lampadina" un bit. Questa parola in inglese significa “un pò” come a dire quindi un “pezzetto” di informazione. Per convenzione si è scelto di rappresentare l’informazione generata ed interpretata dal computer a gruppetti di 8 bit che costituiscono 1 byte.

L’insieme di questi gruppetti di byte, vanno a costituire la memoria digitale che può essere di diverse misure (multipli di byte).

| ACRONIMO | UNITA' DI MISURA | GRANDEZZA |

| Bit | bit | 1 |

| Kb | kilobit | 1000 bit |

| Mb | megabit | 1000 kilobit |

| Gb | gigabit | 1000 megabit |

| Tb | terabit | 1000 gigabit |

| Pb | petabit | 1000 terabit |

| Eb | exabit | 1000 petabit |

| B | byte | 8 bit |

| KB | kilobyte | 1024 byte |

| MB | megabyte | 1024 kilobyte |

| GB | gigabyte | 1024 megabyte |

| TB | terabyte | 1024 gigabyte |

| PB | petabyte | 1024 terabyte |

| EB | exabyte | 1024 petabyte |

Sembra abbiamo trovato un modo, quindi, per rappresentare l'insieme dei numeri interi (ovviamente fino ad un certo limite stabilito dal numero totale di “lampadine”) usando un linguaggio interpretabile dal computer cioè il linguaggio binario detto anche liguaggio macchina basato sui due simboli del sistema binario (1 e 0).

Però sappiamo benissimo che un Computer non rappresenta solo numeri ma anche caratteri alfanumerici (le lettere), immagini e suoni.

Nulla ci vieta di utilizzare una serie di combinazioni “spento-acceso” di una serie di “lampadine” per rappresentare anche lettere, immagini e suoni.

Rappresentazione di dati alfanumerici

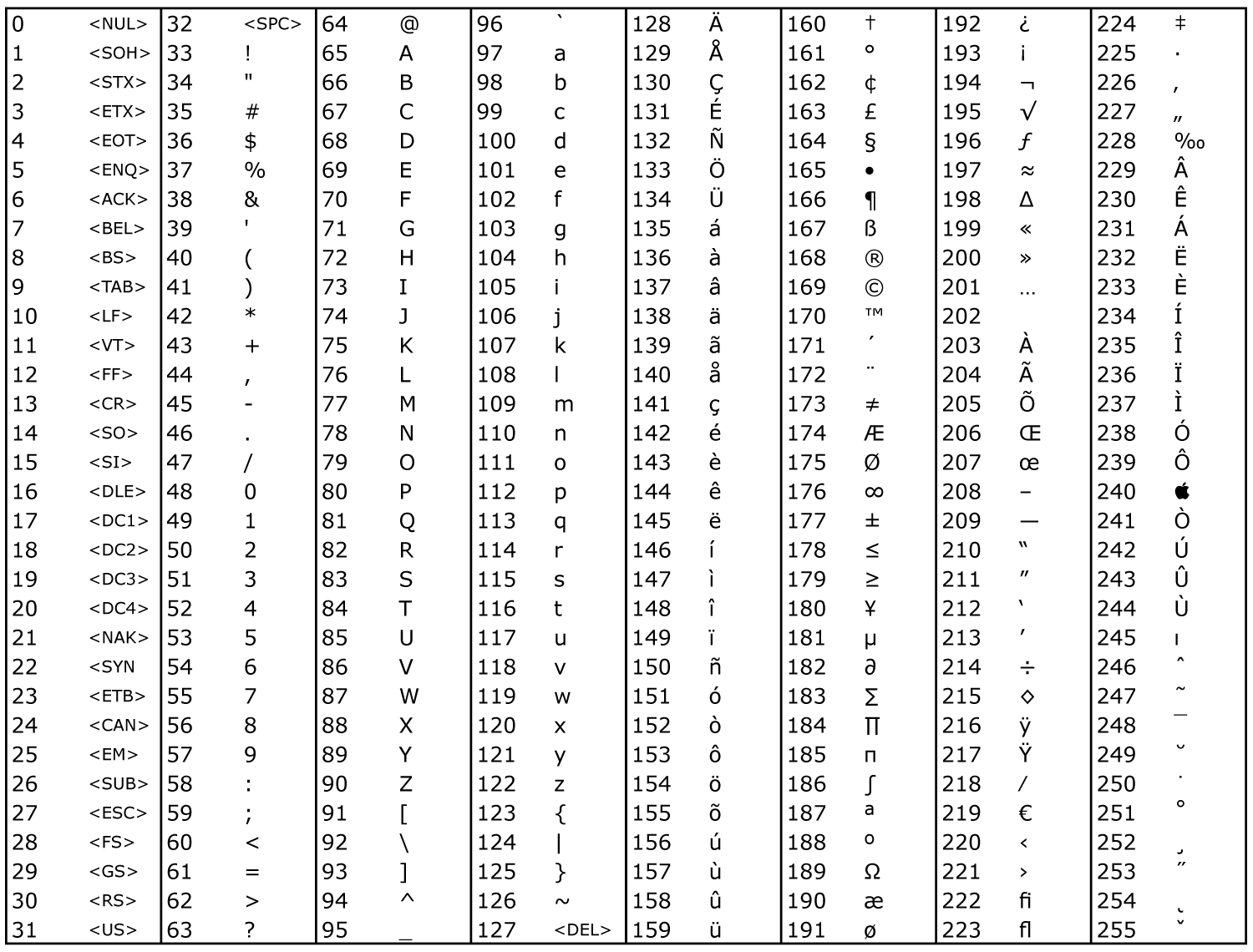

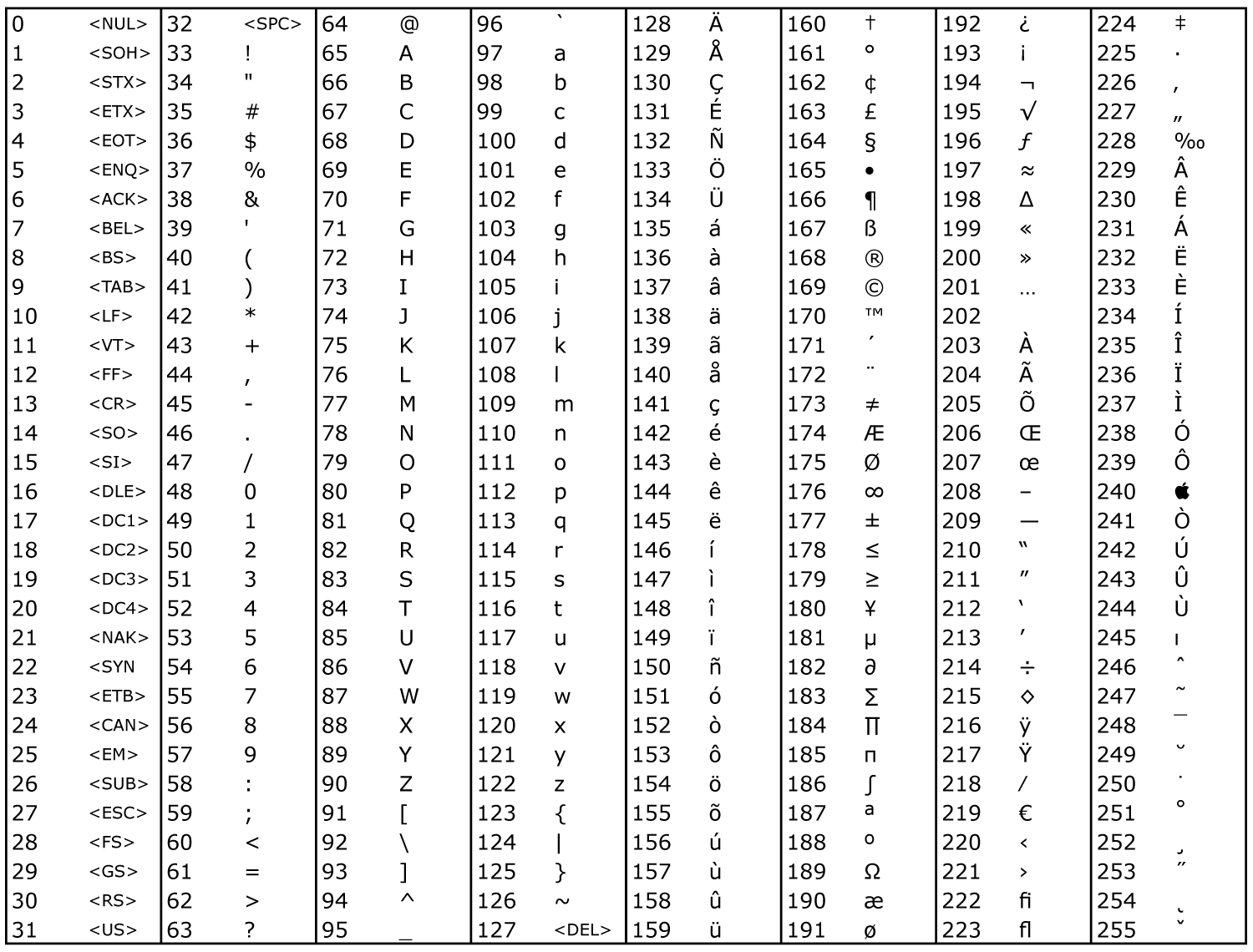

Ad esempio per rappresentare le lettere, si utilizza una tabella di rappresentazione detta tabella ASCII che associa ad una certa sequenza di numeri binari 1 e 0, un determinato valore decimale ed un carattere dell’alfabeto (Fig. 1).

Fig. 1 - Tabella ASCII

Rappresentazione di immagini e video

Stessa cosa potremmo fare per rappresentare una immagine.Immaginiamo una griglia di un certo numero di celle e immaginiamo di riempirla di 0 e 1 con il sitema binario di cui abbiamo parlato. Con il valore 1 rappresenteremo il colore nero mentre con il valore 0 il valore bianco (Fig. 2).

Fig. 2 - Codifica bitmap

Abbiamo rappresentato, con una qualità approssimativa, un rombo. La disposizione delle celle a forma di griglia è una operazione che compirà il monitor che alla ricezione delle informazioni dal nostro Computer come sequenza di 1 e 0. Queste celle sono dette Pixel e la loro codifica è detta codifica bitmap.

Ovviamente possiamo aumentare il numero di bit per celle e rappresentare anche altri colori, oppure aumentare il numero di celle della griglia per ottenere una “qualità” dell’immagine (in termini di dettagli) maggiore che chiameremo risoluzione (densità di pixel in un determinate spazio lineare).

Dietro lo stesso concetto, c’è la rappresentazione dei video. Un video altro non è che una sequenza di immagini che vengono mostrate una dopo l'altra ad una certa velocità. Maggiore è il numero di immagini mostrate al secondo, maggiore è la fluidità del video.

Rappresentazione di suoni

Il ragionamento fatto per la rappresentazione dei carattere e delle immagini (e video) può essere fatto anche per i suoni.Un suono corrisponde fisicamente ad un’onda sonora (pressione dell’aria in un intervallo di tempo), in base all’ampiezza e alla frequenza di tale onda sonora, percepiamo un suono piuttosto che un altro.

A partire da una onda sonora è possibile, attraverso una procedura detta campionamento codificare l’onda stessa in sequenza di valori binari 1 e 0. Il campionamento (Fig. 3) avviene ad ogni intervallo scelto di tempo. Più gli intervalli sono stretti e maggiore è l’accuratezza del campionamento. Questo livello di accuratezza è detto scala e può variare da 8 a 32 bit nell’unità di tempo.

Fig. 3 - Campionamento

Ora che sappiamo come “comunicare” con il Computer e quale linguaggio utilizzare, dobbiamo trovare un modo per “istruirlo” sul tipo di elaborazione che deve effettuare. Ad esempio potremmo volere che il nostro computer effettuasse un calcolo matematico come una somma, una differenza oppure un calcolo logico come un confronto tra numeri per sapere se sono uguali, o uno è maggiore dell’altro e viceversa.

La caratteristica in base alla quale un computer esegue un tipo di operazione piuttosto che un altro è detta programmabilità.

Dobbiamo quindi fornire un programma al computer cioè un insieme di istruzioni in modo tale da poterlo istruire sulle operazioni che vogliamo esegua.

Cosa abbiamo imparato da questa lezione

| Conoscenze |

|

| Abilità |

|

| Competenze |

|